阿里云EMR最佳實踐與容災 構建高可靠的數據處理與存儲服務體系

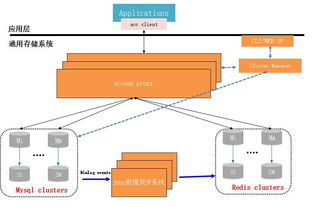

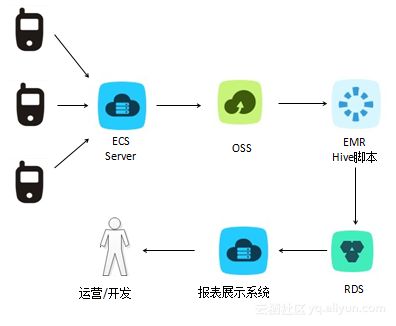

阿里云E-MapReduce(EMR)作為一款全托管的云原生大數據平臺,為企業提供了高效、彈性的數據處理和存儲解決方案。結合最佳實踐與完善的容災策略,可以構建出高可靠、高性能、可擴展的大數據服務架構,確保業務連續性與數據安全。

一、數據處理與存儲服務最佳實踐

1. 集群規劃與資源配置

- 按需選擇節點類型:根據計算密集型(如Spark、Flink)或存儲密集型(如HDFS)工作負載,選擇ECS實例類型(如計算型、大數據型)。計算任務使用計算優化型實例,數據存儲使用本地SSD或高效云盤的大數據型實例,以優化性價比。

- 彈性伸縮策略:利用EMR的彈性伸縮功能,基于集群負載(如YARN資源隊列使用率、CPU/內存指標)自動增加或減少Task節點,在業務高峰時擴容以保證性能,低峰時縮容以節約成本。

- 存儲與計算分離:推薦將數據持久化存儲在OSS(對象存儲)中,而非僅依賴HDFS。OSS提供高持久性、無限擴展和低成本存儲,EMR集群可掛載OSS作為數據湖,實現計算集群的輕量化與靈活啟停。

2. 數據開發與處理優化

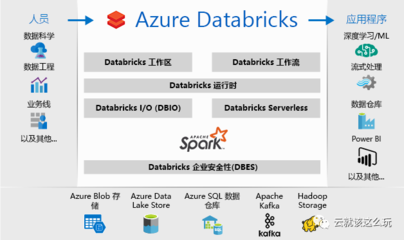

- 作業調度與依賴管理:使用阿里云DataWorks或EMR Workflow進行作業編排,實現復雜DAG任務調度,并設置任務間依賴與失敗重試機制,提升數據處理流水線的可靠性。

- 計算引擎調優:針對Spark、Hive等引擎,根據數據量調整Executor數量、內存分配與并行度;啟用動態資源分配(DRA)以提高資源利用率;對于實時處理,使用Flink并合理設置Checkpoint間隔與狀態后端(如RocksDB)。

- 數據格式與壓縮:采用列式存儲格式(如Parquet、ORC)并配合Snappy或Zstd壓縮,減少I/O與存儲開銷,提升查詢性能。

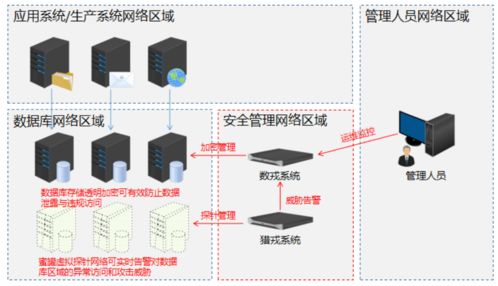

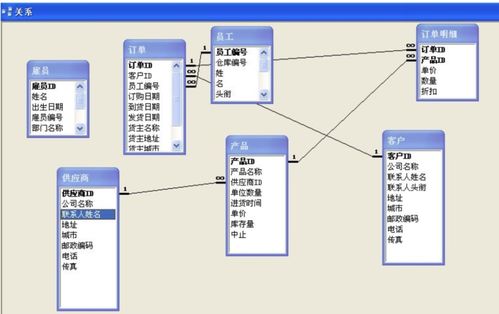

3. 數據管理與安全

- 權限與訪問控制:通過Ranger或RAM(資源訪問管理)實現細粒度的數據權限管控,對Hive表、HDFS路徑、OSS Bucket設置用戶/角色訪問策略,并集成Kerberos進行身份認證。

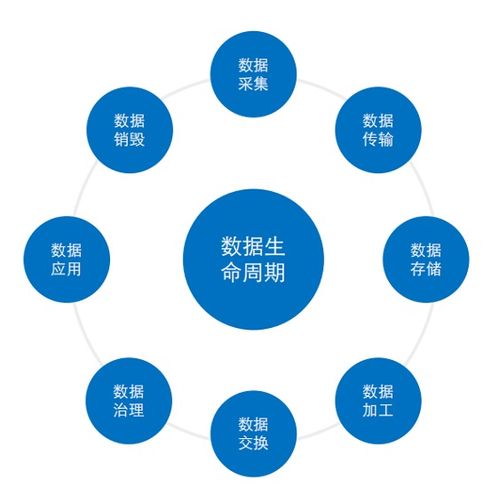

- 數據生命周期管理:結合OSS生命周期規則,將冷數據自動轉換為低頻或歸檔存儲,降低存儲成本;使用EMR Metastore或DLF(數據湖構建)統一管理元數據,確保數據一致性。

- 監控與運維:利用云監控、EMR控制臺和Prometheus監控集群健康度、作業運行狀態與資源使用情況,設置告警閾值(如節點故障、磁盤使用率>80%),并通過日志服務(SLS)集中收集與分析日志。

二、容災架構設計與實施

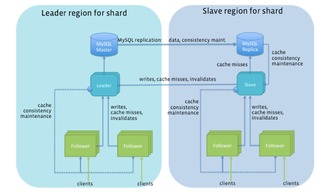

1. 跨可用區(AZ)高可用部署

- 核心組件高可用:在創建EMR集群時,選擇多可用區部署模式,確保Master節點(如HDFS NameNode、YARN ResourceManager)跨AZ分布,避免單點故障。啟用HDFS HA、YARN HA及ZooKeeper集群,保障服務連續性。

- 數據冗余存儲:將原始數據與處理結果同時存儲于OSS,利用OSS的同城冗余存儲(LRS)或跨區域冗余存儲(ZRS/CRR)功能,實現數據跨機房或跨地域復制,滿足不同級別的容災需求。

2. 業務級容災與備份恢復

- 集群級容災:在多個地域(如華東1、華北2)部署獨立的EMR集群,通過Data Integration或DataWorks數據同步任務,將關鍵數據實時或定期同步至災備集群。當主集群發生地域級故障時,可快速切換至災備集群接管數據處理任務。

- 元數據與配置備份:定期備份Hive Metastore、Ranger策略等元數據至OSS或NAS,并利用EMR的集群模板功能保存集群配置,以便在災難發生時快速重建集群。

- 恢復時間目標(RTO)與恢復點目標(RPO)定義:根據業務重要性制定容災預案,明確RTO(如小時級)和RPO(如分鐘級數據丟失)。通過定期容災演練(如切換測試),驗證恢復流程的有效性。

3. 混合云與多云容災擴展

- 對于混合云場景,可通過阿里云高速通道或VPN網關,將本地數據中心與阿里云EMR連通,實現數據雙向同步與災備。利用阿里云DTS(數據傳輸服務)或開源工具(如Sqoop、DistCp)進行數據遷移。

- 考慮多云架構時,可將OSS數據鏡像至其他云存儲服務(如AWS S3),并在其他云平臺部署備用EMR集群(或類似服務),通過腳本自動化實現跨云容災,但需注意網絡延遲與成本管理。

三、

阿里云EMR結合OSS等存儲服務,為企業提供了從數據處理到存儲的全鏈路解決方案。通過遵循最佳實踐優化性能與成本,并設計跨AZ、跨地域乃至跨云的容災架構,可顯著提升大數據服務的可靠性。建議企業根據自身業務需求(如數據規模、實時性要求、合規性)靈活選擇策略,并持續監控與迭代,以構建適應未來發展的數據基礎設施。

如若轉載,請注明出處:http://m.bbmwp.cn/product/49.html

更新時間:2026-01-10 12:44:47